DeepSeek-V3.2 ใหม่

ขับเคลื่อนโดย DeepSeek AI

ขับเคลื่อนโดย DeepSeek AIยินดีต้อนรับสู่ iApp DeepSeek-V3.2 API ที่ขับเคลื่อนโดยโมเดล DeepSeek-V3.2 ล่าสุด API นี้ให้การเข้าถึงโมเดลภาษาขนาดใหญ่แบบโอเพนซอร์สที่ทันสมัยที่สุดตัวหนึ่ง พร้อมความสามารถในการใช้เหตุผลที่ยอดเยี่ยม ประสิทธิภาพที่แข่งขันได้กับ GPT-4 และ Claude Sonnet และอินเทอร์เฟซที่เข้ากันได้กับ OpenAI

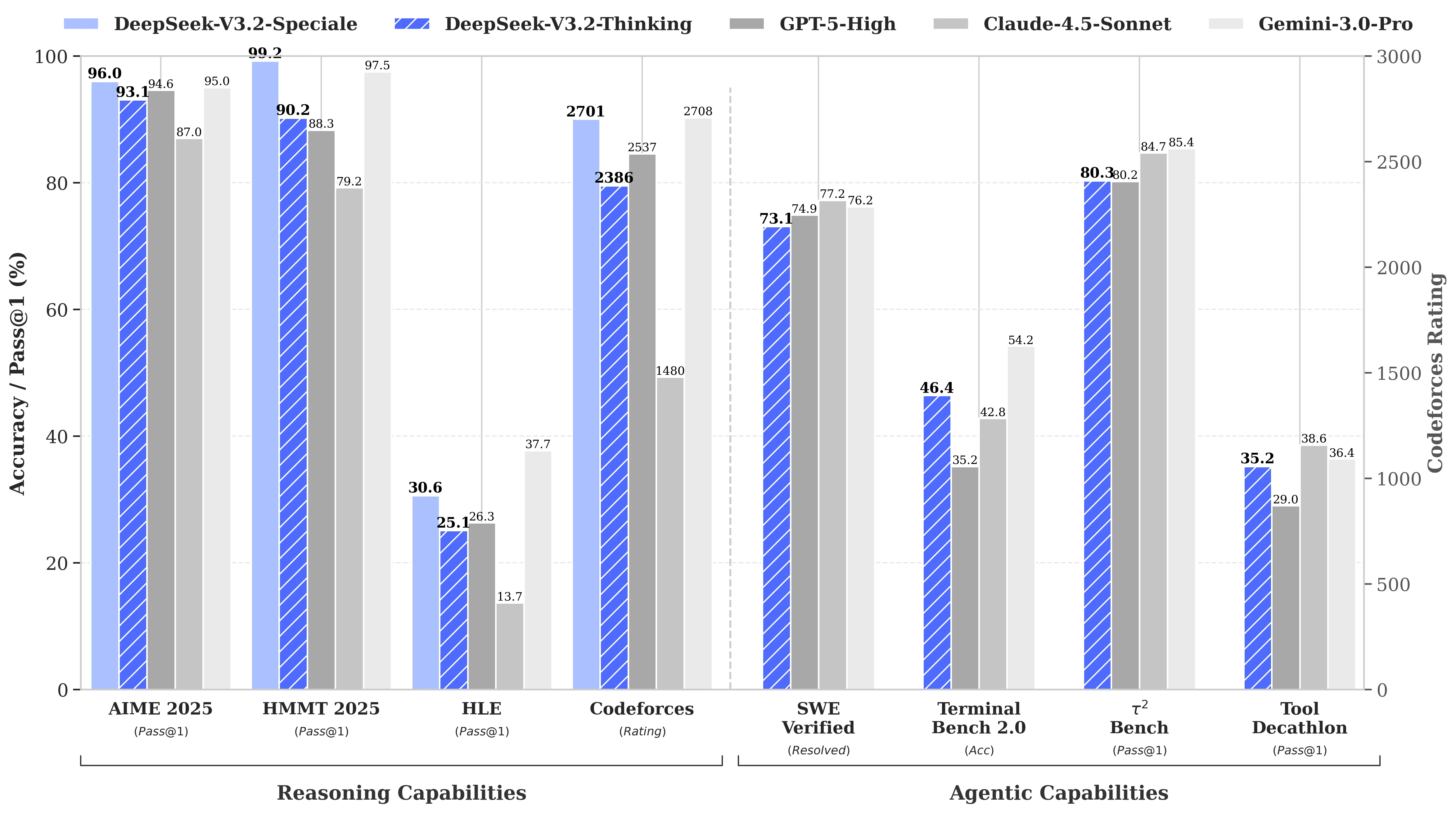

ผลการทดสอบ Benchmark

DeepSeek-V3.2 ให้ประสิทธิภาพที่แข่งขันได้ใน benchmark หลายรายการ:

ไฮไลท์ประสิทธิภาพหลัก

- พารามิเตอร์ 685B: โมเดลขนาดใหญ่พร้อมความสามารถระดับสูงสุด

- ความยาวบริบท 128K: หน้าต่างบริบทขยายสำหรับเอกสารยาว

- โหมด Reasoning: การใช้เหตุผลแบบ chain-of-thought ในตัวด้วยโมเดล

deepseek-reasoner - เข้ากันได้กับ OpenAI: ทดแทน OpenAI API ได้โดยตรง

- ผลงานระดับเหรียญทอง: บรรลุระดับเหรียญทองใน International Mathematical Olympiad (IMO) และ International Olympiad in Informatics (IOI)

ลองใช้งานเดโม

ทดลองใช้ AI Demo

เข้าสู่ระบบหรือสร้างบัญชีฟรีเพื่อใช้งาน AI Demo และสำรวจ API ที่ทรงพลังของเรา

รับ 50 เครดิตฟรี (IC) เมื่อสมัครสมาชิก!

โปรโมชันหมดเขต 31 ธันวาคม 2568

Start a conversation with the AI assistant

Type your message below and press Enter or click Sendภาพรวม

DeepSeek-V3.2 เป็นตัวแทนของโมเดลที่เน้นการใช้เหตุผลขั้นสูงที่ออกแบบมาเพื่อประสานประสิทธิภาพการคำนวณสูงกับการใช้เหตุผลและประสิทธิภาพ agent ที่เหนือกว่า โมเดลนี้แนะนำนวัตกรรมหลัก�สามประการ:

- DeepSeek Sparse Attention (DSA): กลไก attention ที่มีประสิทธิภาพซึ่งลดความซับซ้อนในการคำนวณในขณะที่รักษาประสิทธิภาพสำหรับบริบทขยาย

- Scalable Reinforcement Learning Framework: แนวทาง post-training เพื่อเพิ่มความสามารถในการใช้เหตุผล

- Agentic Task Synthesis Pipeline: ผสานความสามารถในการใช้เหตุผลเข้ากับสถานการณ์การใช้เครื่องมือ

คุณสมบัติหลัก

- การใช้เหตุผลขั้นสูง: โหมดคิดในตัวพร้อมกระบวนการใช้เหตุผลที่ชัดเจน

- เข้ากันได้กับ OpenAI: ตามรูปแบบ OpenAI API สำหรับการผสานรวมที่ง่าย

- รองรับ Streaming: สตรีมโทเค็นแบบเรียลไทม์สำหรับแอปพลิเคชันที่ตอบสนอง

- บริบท 128K: รองรับความยาวบริบทสูงสุด 128,000 โทเค็น

- ไทยและอังกฤษ: รองรับทั้งภาษาไทยและอังกฤษ

- คุ้มค่า: ราคาที่แข่งขันได้สำหรับ AI ระดับองค์กร

เริ่มต้นใช้งาน

-

ข้อกำหนดเบื้องต้น

- API key จาก iApp Technology

- การเชื่อมต่ออินเทอร์เน็ต

-

เริ่มต้นอย่างรวดเร็ว

- อินเทอร์เฟซ REST API ที่เรียบง่าย

- รูปแบบที่เข้ากันได้กับ OpenAI

- รองรับทั้ง streaming และ non-streaming

-

Rate Limits

- 5 คำขอต่อวินาที

- 200 คำขอต่อนาที

กรุณาเยี่ยมชมหน้า การจัดการ API Key เพื่อดู API key ที่มีอยู่หรือขอรับใหม่

API Endpoints

| Endpoint | Method | รายละเอียด | ราคา |

|---|---|---|---|

/v3/llm/deepseek-3p2/chat/completions | POST | Chat completions (streaming และ non-streaming) | 0.01 IC/1K input + 0.02 IC/1K output |

โมเดลที่มีให้บริการ

| โมเดล | รายละเอียด |

|---|---|

deepseek-reasoner | โหมดคิดพร้อมเหตุผลที่ชัดเจน (แนะนำ) |

deepseek-chat | โหมดไม่คิดสำหรับการตอบสนองที่รวดเร็วกว่า |

ตัวอย่างโค้ด

cURL - Non-Streaming

curl -X POST 'https://api.iapp.co.th/v3/llm/deepseek-3p2/chat/completions' \

-H 'apikey: YOUR_API_KEY' \

-H 'Content-Type: application/json' \

-d '{

"model": "deepseek-reasoner",

"messages": [

{"role": "user", "content": "สวัสดีครับ คุณช่วยอะไรได้บ้าง?"}

],

"max_tokens": 4096,

"temperature": 0.7,

"top_p": 0.9

}'

cURL - Streaming

curl -X POST 'https://api.iapp.co.th/v3/llm/deepseek-3p2/chat/completions' \

-H 'apikey: YOUR_API_KEY' \

-H 'Content-Type: application/json' \

-d '{

"model": "deepseek-reasoner",

"messages": [

{"role": "user", "content": "สวัสดีครับ คุณช่วยอะไรได้บ้าง?"}

],

"max_tokens": 4096,

"temperature": 0.7,

"top_p": 0.9,

"stream": true

}'

Response (Non-Streaming with Reasoning)

เมื่อใช้ deepseek-reasoner การตอบกลับจะรวม field reasoning_content ที่แสดงกระบวนการคิดของโมเดล:

{

"id": "233c1fa8-e6ea-4b4f-86b5-2bbccb39fd9e",

"object": "chat.completion",

"created": 1764635256,

"model": "deepseek-reasoner",

"choices": [

{

"index": 0,

"message": {

"role": "assistant",

"content": "สวัสดีครับ! ผมช่วยคุณได้หลายอย่างครับ",

"reasoning_content": "ผู้ใช้ทักทายด้วยคำว่า \"สวัสดี\" ซึ่งเป็นการทักทายพื้นฐานในภาษาไทย ผมควรตอบกลับอย่างเป็นมิตรและเสนอความช่วยเหลือ..."

},

"logprobs": null,

"finish_reason": "stop"

}

],

"usage": {

"prompt_tokens": 12,

"completion_tokens": 109,

"total_tokens": 121

}

}

Python

import requests

import json

url = "https://api.iapp.co.th/v3/llm/deepseek-3p2/chat/completions"

payload = {

"model": "deepseek-reasoner",

"messages": [

{"role": "user", "content": "สวัสดีครับ คุณช่วยอะไรได้บ้าง?"}

],

"max_tokens": 4096,

"temperature": 0.7,

"top_p": 0.9

}

headers = {

'apikey': 'YOUR_API_KEY',

'Content-Type': 'application/json'

}

response = requests.post(url, headers=headers, json=payload)

print(response.json())

JavaScript / Node.js

const axios = require('axios');

const url = 'https://api.iapp.co.th/v3/llm/deepseek-3p2/chat/completions';

const payload = {

model: 'deepseek-reasoner',

messages: [

{ role: 'user', content: 'สวัสดีครับ คุณช่วยอะไรได้บ้าง?' }

],

max_tokens: 4096,

temperature: 0.7,

top_p: 0.9

};

const config = {

headers: {

'apikey': 'YOUR_API_KEY',

'Content-Type': 'application/json'

}

};

axios.post(url, payload, config)

.then(response => {

console.log(response.data.choices[0].message.content);

})

.catch(error => {

console.error(error);

});

API Reference

Headers

| พารามิเตอร์ | ประเภท | จำเป็น | รายละเอียด |

|---|---|---|---|

| apikey | String | ใช่ | API key ของคุณ |

| Content-Type | String | ใช่ | application/json |

Request Body Parameters

| พารามิเตอร์ | ประเภท | จำเป็น | รายละเอียด |

|---|---|---|---|

| model | String | ใช่ | ชื่อโมเดล: deepseek-reasoner หรือ deepseek-chat |

| messages | Array | ใช่ | อาร์เรย์ของ message objects พร้อม role และ content |

| max_tokens | Integer | ไม่ | โทเค็นสูงสุดที่จะสร้าง (ค่าเริ่มต้น: 4096, สูงสุด: 128000) |

| stream | Boolean | ไม่ | เปิดใช้งาน streaming response (ค่าเริ่มต้น: false) |

| temperature | Float | ไม่ | Sampling temperature 0-2 (ค่าเริ่มต้น: 0.7) |

| top_p | Float | ไม่ | Nucleus sampling (ค่าเริ่มต้น: 0.9) |

Message Object

| Field | ประเภท | รายละเอียด |

|---|---|---|

| role | String | system, user, หรือ assistant |

| content | String | เนื้อหาข้อความ |

Response Fields

| Field | ประเภท | รายละเอียด |

|---|---|---|

| content | String | การตอบกลับที่สร้างขึ้น |

| reasoning_content | String | (deepseek-reasoner เท่านั้น) กระบวนการใช้เหตุผล |

การตั้งค่า Temperature ที่แนะนำ

| กรณีใช้งาน | Temperature |

|---|---|

| เขียนโค้ด / คณิตศาสตร์ | 0.0 |

| วิเคราะห์ข้อมูล | 1.0 |

| สนทนาทั่วไป | 1.3 |

| แปลภาษา | 1.3 |

| เขียนเชิงสร้างสรรค์ | 1.5 |

ข้อมูลโมเดล

| คุณสมบัติ | ค่า |

|---|---|

| ชื่อโมเดล | deepseek-reasoner / deepseek-chat |

| โมเดลพื้นฐาน | DeepSeek-V3.2 |

| พารามิเตอร์ | 685B |

| ความยาวบริบท | 128,000 โทเค็น |

| ภาษา | ไทย, อังกฤษ, จีน, และอื่นๆ |

| สัญญาอนุญาต | MIT |

กรณีใช้งาน

- การใช้เหตุผลขั้นสูง: แก้ปัญหาซับซ้อน, พิสูจน์ทางคณิตศาสตร์, การอนุมานเชิงตรรกะ

- ช่วยเขียนโค้ด: สร้างโค้ด, ดีบัก, อธิบายโค้ด

- สร้างเนื้อหา: บทความ, รายงาน, เขียนเชิงสร้างสรรค์ในหลายภาษา

- แปลภาษา: แปลคุณภาพสูงระหว่างไทย, อังกฤษ, และภาษาอื่นๆ

- ระบบถาม-ตอบ: ตอบคำถามอัจฉริยะพร้อมความสามารถในการใช้เหตุผล

- วิเคราะห์ข้อมูล: ตีความข้อมูลและสร้าง insights

ราคา

| ชื่อบริการ AI API | Endpoint | ราคา IC | On-Premise |

|---|---|---|---|

| DeepSeek-V3.2 [v3.2] | /v3/llm/deepseek-3p2/chat/completions | Input: 0.01 IC / 1K โทเค็น (~10 บาท/1M, ~$0.30/1M) | ติดต่อ |

ช่องทางสนับสนุน

สำหรับการสนับสนุนและคำถาม:

- Discord: เข้าร่วมชุมชนของเรา

- อีเมล: support@iapp.co.th

- เอกสาร: เอกสาร API ฉบับเต็ม